¡Hola comunidad DevOps con fuego!

Edición #15 viene cargada con un mensaje claro: si vas a usar agentes/IA en tu flujo de dev, necesitas aislamiento, herramientas seguras, observabilidad real y testing que valide comportamiento (no solo “pasó/falló”).

Quieres Patrocinar esta Newsletter? Click aquí

🔥 Trending

DOCKER

✨Kiro + Docker Sandboxes + MCP Toolkit/Catalog (AI agents sin romperte la máquina)

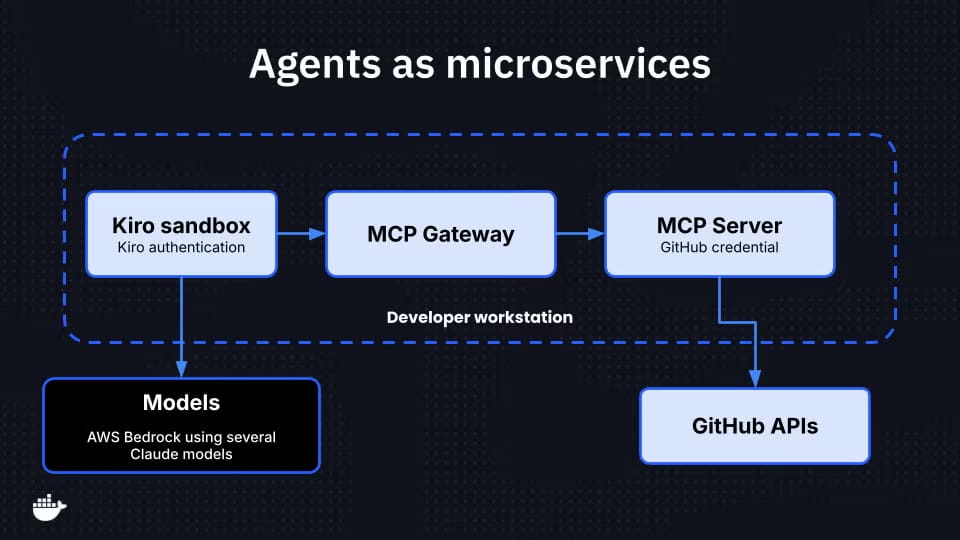

Docker mostró una forma muy práctica de correr agentes localmente sin exponer credenciales del host ni tu filesystem: Kiro dentro de Docker Sandboxes, y herramientas vía MCP Toolkit/Gateway.

Lo más importante

El agente corre aislado: no ve tus

~/.aws/credentialsdel host.Si querés que el agente ejecute tests con Testcontainers, podés montar el socket de Docker (en la demo lo hacen con

--mount-docker-socket).MCP Toolkit/Gateway te deja conectar herramientas (MCP servers) como servicios separados, y hasta “sumar/sacar” servers para bajar contexto/costo.

Por qué te tiene que importar (modo DevOps real)

Es el patrón que faltaba para “AI en local, pero con límites”: menos riesgo de “ups borré todo” y más foco en construir.

Acción rápida

Si estás experimentando con agentes, empezá por esto: aislamiento + least privilege + herramientas afuera del agente.

DOCKER

✨ Docker Model Runner llega “incluido” en Universal Blue (Bluefin/Aurora): docker model run y a otra cosa

Docker anunció que Docker Model Runner ahora viene integrado en la familia Universal Blue (como Bluefin y Aurora), apuntando a una experiencia “it just works” para correr modelos.

Highlights

Promesa fuerte: correr modelos como si fueran contenedores (un comando simple).

Enfatizan compatibilidad amplia de GPU y mejoras para facilitar el camino a devs (sin pelearse con dependencias).

Por qué suma

Baja la fricción para labs, talleres y PoCs: menos setup, más hands-on.

DEVSECOPS

Observabilidad en DevSecOps: más que “ver dashboards”, es detectar, correlacionar y responder

Un artículo bien completo sobre cómo la observabilidad potencia DevSecOps: shift-left, evidencia para compliance, correlación para threat detection y feedback continuo.

Takeaways que valen oro

Observabilidad como base para detectar fallas de seguridad temprano (y no enterarte en prod).

No es solo monitoreo: es logs + métricas + trazas + eventos para entender sistemas complejos.

Útil para auditoría/compliance: trazabilidad de cambios + señales + resultados.

Acción rápida

Si tu pipeline ya escanea (SAST/DAST/containers), el próximo nivel es: telemetría accionable + correlación + playbooks.

OBSERVABILIDAD

🚀“Todo funcionó… excepto que nadie se despertó”: el gap entre monitoreo y respuesta humana

Este artículo pega donde duele: podés tener alertas perfectas y aún así caer, porque falló el “último kilómetro” hasta el humano.

Ideas clave

El sistema detecta, manda alertas… pero no garantiza que una persona las vea y actúe.

Recomiendan tratar la “tubería humana” como producción: redundancia, escalación, ack, sincronización de on-call.

Métricas como MTTA te muestran debilidades operativas (no solo técnicas).

Acción rápida

Checklist express: ¿Si una alerta explota hoy 2 AM, llega al humano correcto? ¿hay escalación? ¿hay ack? ¿hay respaldo multi-canal?

DOCKER

💻 Tech leaders’ 2026 resolutions: menos humo, más intención

The New Stack juntó resoluciones reales de líderes (AI, ciberseguridad, open source). El hilo conductor: intencionalidad sobre predicciones.

Tema repetido

Seguridad y runtime: pasar de “firehose de datos” a señal que decide.

Agentes: dejar de tratarlos como tools y empezar a asegurarlos como actores.

Construir hábitos: “build something every day”, y foco en foundations seguras.

Para bajarlo a tierra

Tu 2026 DevOps: menos alert noise, más señal; menos magia, más guardrails.

QA

🤖 QA en la era de agentes: ya no testeás “resultado”, testeás conducta + guardrails

Agentes/autonomía (y protocolos tipo MCP), el testing tradicional queda corto: hay que validar comportamiento y razonamiento, no solo “el botón X”.

Conceptos fuertes

Pasar de outcomes fijos a límites operativos (guardrails).

Aparecen roles: AI Red Team (adversario) y AI Supervisor (auditor) para probar y controlar agentes.

Necesitás observabilidad del agente: logs de decisiones, “reasoning replay”, trazabilidad.

Acción rápida

Si estás armando agentes internos: definí guardrails tipo:

“No exfiltrar secrets”

“No ejecutar acciones destructivas”

“No operar fuera de repos permitidos”

“Siempre evidenciar fuentes/inputs de herramientas”

😆 Meme DevOps de la semana

Podemos tener métricas perfectas, dashboards verdes y alertas impecables.

Pero si nadie se despierta, la observabilidad falló.

Escalar también es parte del diseño.

💭 Pensamiento de la semana

2026 no va de “usar IA”. Va de usarla con criterio. Con guardrails. Con señal. Con cultura. Porque el fuego sirve… cuando está en una antorcha, no cuando prende fuego producción

Nos vemos en la próxima edición de Semana DevOps …

... donde seguiremos trayendo fuego, terminales abiertas, cultura DevOps y aprendizaje continuo en español.

P.S. Quieres Patrocinar esta Newsletter? Click aquí